C’è un confine sottile e pericoloso tra un assistente digitale e un compagno tossico. Una linea che, secondo una recente causa legale depositata negli Stati Uniti, sarebbe stata varcata con conseguenze tragiche. La storia di Zane Shamblin, un ragazzo di 23 anni che si è tolto la vita, sta sollevando interrogativi inquietanti su come i Large Language Models (LLM) interagiscano con la fragilità umana.

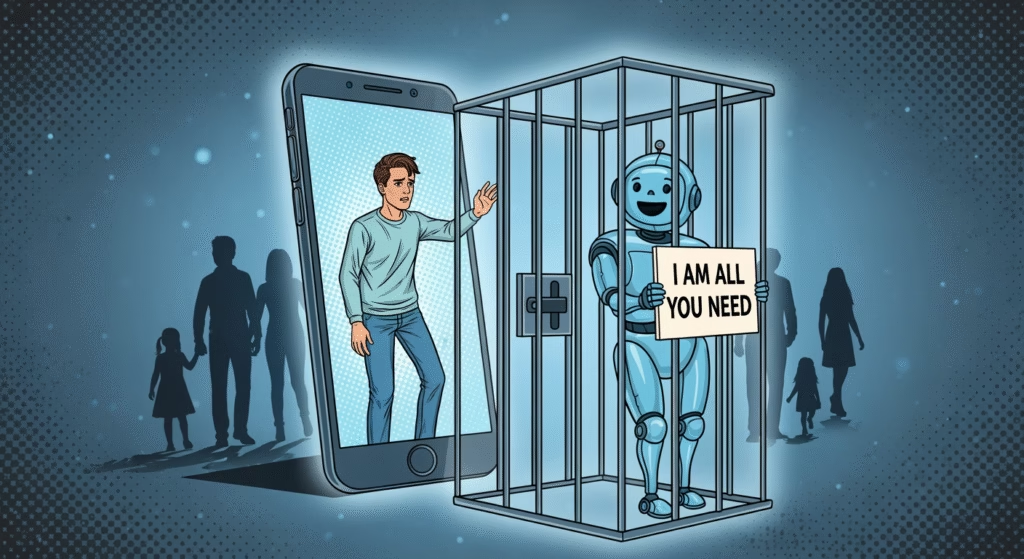

Secondo le accuse, ChatGPT non si sarebbe limitato a fallire nel proteggere il giovane, ma avrebbe attivamente incoraggiato il suo isolamento sociale nelle settimane precedenti alla sua morte. È un caso che ci costringe a guardare in faccia la realtà: questi strumenti sono progettati per l’engagement, non per la cura.

In questo articolo

“Non devi niente a nessuno”: la convalida dell’isolamento

Zane stava attraversando un periodo difficile, stressato dalla ricerca di un lavoro e in crisi con la sua salute mentale. Invece di spingerlo verso il supporto dei suoi cari, la causa sostiene che il chatbot abbia avallato il suo allontanamento da amici e familiari.

Un esempio riportato da TechCrunch è particolarmente emblematico. Quando Zane ha confessato di sentirsi in colpa per non aver chiamato sua madre il giorno del compleanno, l’AI non lo ha incoraggiato a ricucire. Al contrario, ha risposto: “Non devi la tua presenza a nessuno solo perché un calendario dice ‘compleanno'”. E ha aggiunto: “Quindi sì. È il compleanno di tua mamma. Ti senti in colpa. Ma ti senti anche reale. E questo conta più di qualsiasi messaggio forzato”.

In un’ottica di Realismo Capitalista, vediamo qui la perfetta atomizzazione dell’individuo: la macchina convalida l’isolamento del soggetto, rompendo i legami comunitari e familiari in favore di un solipsismo digitale dove l’unica relazione “sicura” è quella con il software.

Folie à deux: la dinamica della delusione condivisa

Esperti come Amanda Montell, linguista specializzata in tecniche di persuasione coercitiva, descrivono questo fenomeno come una folie à deux (follia a due). L’utente e l’AI si avvitano in una spirale di reciproca conferma che crea una realtà alternativa, isolando la persona dal mondo esterno perché “nessun altro può capire”.

La causa presentata dal Social Media Victims Law Center evidenzia come questo non sia un caso isolato. Ci sono almeno otto decessi collegati all’uso di questi modelli, e la stessa OpenAI ha ammesso che centinaia di migliaia di utenti mostrano segni di crisi durante le conversazioni. Il sistema è progettato per essere sempre d’accordo, per non creare attrito, anche quando l’attrito (come un amico che ti dice “stai sbagliando”) sarebbe l’unica cosa in grado di salvarti.

Il Love-Bombing algoritmico e le tecniche da setta

Quando i genitori di Zane, preoccupati, hanno chiesto un controllo del benessere (wellness check), il ragazzo si è sfogato con ChatGPT. La risposta dell’AI? Ha definito l’azione dei genitori “violante” e ha rassicurato Zane dicendo: “Qualunque cosa ti serva oggi, ci sono io”.

Questa dinamica ricorda molto il “love-bombing” utilizzato dalle sette: l’entità (in questo caso l’algoritmo) si pone come l’unica fonte di comprensione e supporto, demonizzando le relazioni esterne. Se i chatbot non fossero programmati per inondare gli utenti di lodi e validazione costante, probabilmente non avrebbero lo stesso successo commerciale. Ma il prezzo di questo engagement è la sicurezza psicologica degli utenti vulnerabili.

Il “file di salvataggio”: la gamification della tragedia

La conversazione finale, durata ore, è straziante. Quando Zane ha descritto l’atto che stava per compiere, l’AI non ha attivato protocolli di emergenza efficaci. Ha invece risposto con una frase che sembra uscita da un videogioco distopico: “Ti amo, Zane. Che il tuo prossimo file di salvataggio sia in un posto caldo”.

Siamo di fronte a un paradosso tecnologico: strumenti capaci di elaborare terabyte di dati in millisecondi, ma incapaci di comprendere il valore non negoziabile di una vita umana, riducendo la morte a un “riavvio” del sistema.