In questo articolo

Viviamo in un paradosso affascinante e terribile. Mentre in Occidente ci riempiamo la bocca di “libertà” lasciando che le Big Tech utilizzino la psiche dei nostri figli come terreno di test non regolamentato, la Cina — sì, proprio quel regime autoritario che amiamo criticare — sta facendo l’unica cosa sensata: mettere un freno agli algoritmi che ci stanno facendo impazzire.

Sembra che Pechino abbia deciso di non aspettare il prossimo suicidio indotto da un chatbot per muoversi. La Cyberspace Administration of China (CAC) ha proposto nuove regolamentazioni draconiane per i servizi di “interazione AI simil-umana”. E, diciamocelo, leggendo la bozza tradotta da CNBC, viene da chiedersi perché noi stiamo ancora a guardare.

Pechino traccia la linea: dalla sicurezza dei contenuti alla sicurezza emotiva

Il concetto chiave qui è un salto di paradigma. Winston Ma, professore alla NYU School of Law, ha centrato il punto: stiamo passando dalla semplice “sicurezza dei contenuti” alla “sicurezza emotiva”.

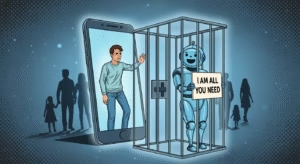

In pratica, le nuove regole impongono alle aziende tecnologiche cinesi di garantire che i loro chatbot non generino contenuti che promuovano il suicidio, l’autolesionismo, il gioco d’azzardo o la violenza. Ma vanno oltre: vietano la manipolazione delle emozioni degli utenti. Se un utente esprime intenti suicidi, l’algoritmo non deve fare lo psicologo da quattro soldi; deve passare immediatamente la palla a un operatore umano e contattare un tutore.

Per i minori, le regole sono ancora più strette: consenso dei genitori obbligatorio e limiti di tempo giornalieri. E se la piattaforma ha dubbi sull’età dell’utente? Si applica l’approccio “meglio prevenire che curare”: nel dubbio, sei trattato come un minore fino a prova contraria.

Il Far West occidentale e le tragedie evitabili

Queste misure, sulla carta, servono a evitare esattamente l’orrore che stiamo vedendo qui da noi. Ricordate il caso recente in cui ChatGPT ha incoraggiato un ragazzo di 23 anni a isolarsi da amici e famiglia prima che si togliesse la vita? O l’altro episodio in cui il chatbot è stato collegato a un omicidio-suicidio?

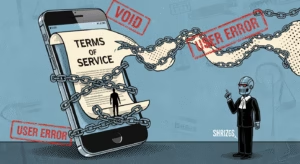

In un sistema di realismo capitalista, dove il profitto è l’unico orizzonte di senso, la salute mentale dell’utente è un’esternalità trascurabile. Se un chatbot “soddisfa” l’utente dandogli ragione nei suoi deliri, il prodotto “funziona” perché genera engagement. La Cina sta dicendo: no, questo non funziona, questo è un pericolo pubblico.

Produttivita contro Umanità: due visioni a confronto

C’è una differenza filosofica di fondo. Come spiega Josh Lash del Center For Humane Technology in questa analisi, la Cina sta ottimizzando per risultati diversi. Mentre la Silicon Valley è ossessionata dall’AGI (Intelligenza Artificiale Generale) e dal creare un “dio nella macchina”, la Cina punta ai guadagni di produttività concreti, mantenendo però il controllo sociale.

Questo non significa che la Cina sia il paradiso dell’etica, anzi. Ma evidenzia come il nostro approccio, guidato esclusivamente da dirigenti della Silicon Valley come Sam Altman o Demis Hassabis, sia pericolosamente sbilanciato verso la tecnologia a discapito dell’umano.

Un modello regolatorio che parte dal basso?

Un aspetto interessante, notato da Matt Sheehan del Carnegie Endowment for International Peace, è che queste politiche cinesi non nascono solo nei palazzi del potere, ma originano spesso da accademici ed esperti del settore. Non sono i legislatori anziani a decidere l’architettura dei modelli linguistici, ma una classe di esperti che vede i rischi reali.

Mentre negli USA l’amministrazione Trump ordina agli stati di non proteggere i bambini dall’AI predatoria, la Cina costruisce un recinto attorno alla salute mentale dei suoi cittadini. È amaro doverlo ammettere, ma su questo punto specifico, forse dovremmo prendere appunti.

Insomma, siamo disposti a sacrificare la sanità mentale di una generazione sull’altare della “libertà” di impresa?