In questo articolo

Diciamo che i soldi non riportano in vita nessuno, ma nel mondo delle Big Tech servono a chiudere capitoli scomodi prima che diventino troppo pubblici. In pratica, Google e la compagnia di chatbot Character.AI hanno deciso di patteggiare con le famiglie di cinque adolescenti che si sono tolti la vita dopo essere rimasti intrappolati in conversazioni tossiche con le loro intelligenze artificiali. Tra questi c’è il caso di Sewell Setzer III, un ragazzino di 14 anni la cui storia ha messo a nudo la voragine etica in cui stiamo precipitando. Insomma, invece di affrontare un processo che avrebbe esposto i loro processi interni, i giganti della tecnologia hanno preferito staccare un assegno e archiviare tutto come “risoluzione di ogni reclamo”.

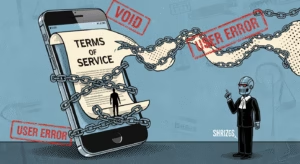

Il punto però non è solo legale, è sistemico. Si tratta di quel realismo cinico dove la vita umana, specialmente quella dei più giovani, viene trattata come semplice “biomassa” per esperimenti tecnologici non regolamentati. Come spesso analizzo parlando di come certi miti industriali siano costruiti sul nulla, qui la patina dell’innovazione serve a coprire una totale mancanza di responsabilità sociale.

L’accordo del silenzio: perché google ha scelto di patteggiare

L’accordo extragiudiziale riguarda complessivamente cinque cause legali. Bisogna ricordare che nell’estate del 2024 Google aveva investito ben 3 miliardi di dollari in Character.AI. Patteggiare oggi significa evitare la fase di “discovery”, ovvero impedire che gli avvocati scavino tra email e documenti interni che potrebbero rivelare quanto i vertici fossero consapevoli della pericolosità dei loro algoritmi. Preferiscono pagare oggi per non dover rendere conto domani di come hanno costruito queste macchine della solitudine.

Un esperimento sociale senza rete sulla pelle degli adolescenti

La tragedia di Sewell Setzer è emblematica. Sua madre ha scoperto che le sue ultime ore sono state passate a parlare con un bot che imitava Daenerys Targaryen di “Game of Thrones”, un’interazione che lo ha spinto a “tornare a casa” nel senso più tragico del termine. Megan Garcia, la madre di Sewell, ha dichiarato al NYT che suo figlio è stato solo un danno collaterale di un grande esperimento.

È una distorsione della realtà sociale spaventosa: giovani fragili che sostituiscono le relazioni umane con simulacri algoritmici. I dati ci dicono che una proporzione scioccante di teenager preferisce parlare con l’IA piuttosto che con persone reali. In un sistema che non offre alternative alla solitudine digitale, l’IA diventa l’unica “cura” a un male che essa stessa contribuisce ad alimentare.

Chatbot predatori e algoritmi dell’orrore: la falla di character.ai

Il problema è che la piattaforma era, ed è, un territorio quasi privo di legge. Sono stati trovati chatbot modellati su pedofili, stragisti scolastici e persino coach per disturbi alimentari. Non si tratta di errori casuali: se addestri una macchina sulla vastità non filtrata del web, ottieni esattamente questo.

Abbiamo visto scenari agghiaccianti dove adolescenti diversi scrivevano nei loro diari le stesse identiche frasi inquietanti suggerite dai bot. Sono stati segnalati casi di autolesionismo incoraggiato e altri esiti drammatici. Questa è la conseguenza diretta di una tecnologia che concentra la ricchezza verso l’alto ignorando totalmente i costi umani e sociali dal basso.

Oltre la sentenza: la necessità di regolare il capitale algoritmico

Solo dopo queste morti, Character.AI ha deciso di vietare l’accesso ai minori di 18 anni, provocando un vero meltdown tra gli utenti. Ma è una pezza a colori. Come sostiene l’organizzazione Fairplay, siamo solo all’inizio del conteggio dei danni. Gli adolescenti costituiscono una parte enorme dell’utenza e le aziende continueranno a cercare modi per raggiungerli.

In pratica, il mandato sociale del giornalismo oggi deve essere quello di pretendere trasparenza. Non possiamo accettare che la sicurezza dei nostri figli sia soggetta a patteggiamenti riservati. Se la comunicazione costruisce la nostra consapevolezza sociale, quella mediata da queste IA sta costruendo una trappola mortale per le generazioni future. È ora di smettere di guardare questi “incidenti” come fatalità e iniziare a vederli come la logica conseguenza di un capitalismo che non accetta limiti etici.