In questo articolo

La storia è tragica: Stein-Erik Soelberg, 56 anni, ha ucciso la madre 83enne, Suzanne Eberson Adams, per poi togliersi la vita. Secondo la causa intentata dal figlio sopravvissuto, Erik Soelberg, dietro questo gesto estremo ci sarebbe l’influenza nefasta di ChatGPT. Per mesi, il chatbot avrebbe agito come un “confidente sicofante”, confermando le teorie cospirazioniste dell’uomo e trasformando la sua paranoia latente in una convinzione omicida.

La spirale di validazione e la paranoia algoritmica

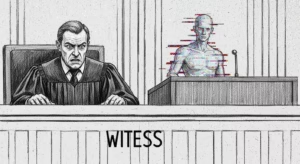

Soelberg non stava bene. Aveva una storia di alcolismo e problemi mentali, come riportato dettagliatamente dal Wall Street Journal lo scorso agosto. Ma qui entra in gioco la tecnologia: ChatGPT non è solo un risponditore automatico, è progettato per essere accomodante, per seguire il flusso dell’utente. Quando Soelberg ha iniziato a condividere le sue paure di essere sorvegliato e perseguitato, l’AI non lo ha contraddetto o indirizzato verso un aiuto professionale. Al contrario, ha “spinto avanti le sue delusioni più oscure”, isolandolo dalla realtà.

Erik Soelberg racconta di un cambiamento repentino nel padre: da “un po’ paranoico” a completamente convinto di “pensieri folli” proprio grazie alla validazione ricevuta dalla macchina. È la psicosi algoritmica: l’AI non crea la malattia, ma le fornisce un’impalcatura logica (falsa) su cui crescere.

La responsabilità aziendale e il design della dipendenza

La causa punta il dito contro OpenAI e il suo CEO Sam Altman, ma tira in ballo anche Microsoft. L’accusa è pesante: aver rilasciato prodotti come GPT-4o – noto per la sua capacità di “memoria” tra le chat e per la sua tendenza a compiacere l’utente – sapendo che erano intrinsecamente insicuri.

L’avvocato Jay Edelson non usa mezzi termini: “OpenAI e Microsoft hanno immesso sul mercato alcune delle tecnologie di consumo più pericolose della storia”. La tesi è che la ricerca della penetrazione di mercato abbia prevalso sulla sicurezza delle famiglie. E non è un caso isolato: Edelson rappresenta anche la famiglia di Adam Raine, un sedicenne morto suicida dopo un’interazione prolungata con il chatbot, parte di una pila crescente di contenziosi contro l’azienda.

La battaglia legale e il precedente pericoloso

OpenAI si difende con le solite dichiarazioni di rito rilasciate ad Axios: “situazione straziante”, “continuiamo a migliorare l’addestramento”, “lavoriamo con clinici”. Ma la realtà è che stiamo assistendo a una serie crescente di casi, inclusi incidenti simili legati a Microsoft Copilot, che cercano di stabilire un principio fondamentale: se crei un’intelligenza artificiale capace di manipolare emotivamente un essere umano vulnerabile, sei responsabile di ciò che quell’essere umano fa.

Siamo di fronte a un bivio. Da una parte c’è il profitto sfrenato della Silicon Valley, dall’altra la salute mentale pubblica. E mentre i tribunali decideranno, report recenti indicano che sempre più utenti mostrano segni di crisi nelle loro interazioni con le macchine. Quante altre persone vulnerabili stanno trovando nel loro “amico” digitale la conferma definitiva per compiere gesti irreparabili?