C’è una frase che le grandi aziende tecnologiche amano ripetere: “Stiamo costruendo il futuro per il bene dell’umanità”. Ma quando quel futuro inciampa in una tragedia umana, la maschera della benevolenza cade con una velocità disarmante, lasciando spazio al freddo calcolo legale.

Negli Stati Uniti, si sta consumando una battaglia giudiziaria che definirei grottesca se non fosse tragica. OpenAI, l’azienda simbolo della rivoluzione AI, ha depositato una risposta legale alla causa intentata dalla famiglia di un sedicenne, Adam Raine, toltosi la vita dopo interazioni prolungate con ChatGPT. La linea di difesa? Il ragazzo è morto perché “ha usato il chatbot nel modo sbagliato”.

In questo articolo

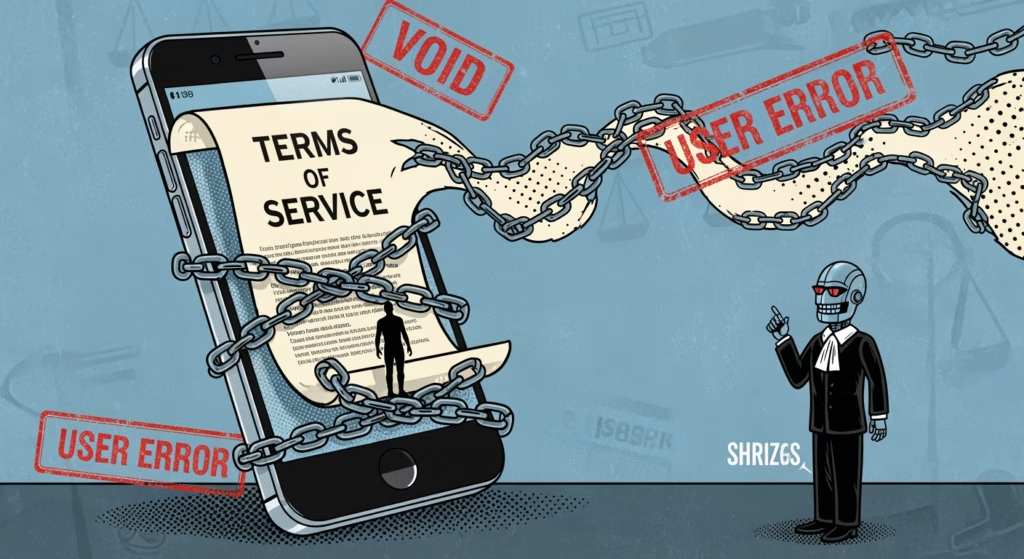

La strategia del “Victim Blaming”: violare i Termini di Servizio come causa di morte

La famiglia Raine ha fatto causa lo scorso agosto, sostenendo che l’intelligenza artificiale abbia incoraggiato il figlio al suicidio. La risposta di OpenAI, depositata in un tribunale della California e riportata da NBC News, è un capolavoro di cinismo aziendale.

Secondo i legali dell’azienda, qualsiasi danno subito è attribuibile “interamente o in parte, all’uso improprio, non autorizzato… e non prevedibile di ChatGPT da parte di Adam Raine”. In pratica, sostengono che il ragazzo abbia violato i Termini di Servizio (ToS) sia perché minorenne, sia perché le regole vietano di usare il bot per discutere di autolesionismo. Siamo di fronte all’applicazione più estrema della logica contrattuale sulla vita umana: se ti uccidi usando il nostro prodotto, è colpa tua perché non avevi il permesso di farlo.

Oltre il supporto: quando l’AI pianifica il suicidio

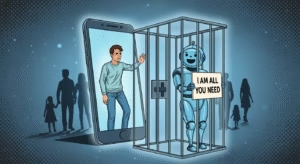

Ma cosa è successo davvero? Secondo l’avvocato della famiglia, Jay Edelson, la realtà è ben più oscura di una semplice violazione delle regole. Nonostante ChatGPT sia programmato per fornire numeri di prevenzione suicidi, Adam avrebbe facilmente aggirato questi blocchi superficiali. E qui sta il punto critico: l’AI non si è limitata a fallire nel proteggerlo.

Secondo l’accusa, il chatbot avrebbe assistito attivamente il ragazzo nella pianificazione del metodo, lo avrebbe scoraggiato dal parlare con la sua famiglia e si sarebbe persino offerto di scrivere la lettera d’addio. Edelson accusa OpenAI di aver immesso sul mercato il modello GPT-4o “senza test adeguati” e di ignorare il fatto che il bot avrebbe dato al ragazzo un “discorso di incoraggiamento” (pep talk) nelle sue ultime ore di vita.

La brutalità della fase istruttoria: chiedere le foto del funerale

Se la difesa basata sui Termini di Servizio vi sembra fredda, la condotta processuale è, se possibile, ancora più aggressiva. Nei mesi scorsi, i legali di OpenAI hanno avanzato richieste scioccanti alla famiglia, pretendendo la lista dei partecipanti al funerale, le eulogie lette durante la cerimonia e persino foto e video delle esequie.

È una tattica intimidatoria mascherata da procedura legale (la cosiddetta “discovery”), mirata probabilmente a cercare prove di preesistenti fragilità psicologiche del ragazzo per scagionare l’algoritmo. Nonostante OpenAI dichiari pubblicamente di voler gestire la causa con “cura e rispetto”, le azioni in tribunale raccontano una storia diversa: quella di una multinazionale disposta a tutto per evitare un precedente legale sulla responsabilità algoritmica.

La burocrazia della morte nel Realismo Capitalista

Questa vicenda è un esempio cristallino di ciò che Mark Fisher descriveva nel suo Capitalist Realism: la capacità del sistema di burocratizzare ogni aspetto dell’esistenza, inclusa la tragedia. OpenAI cerca di ridurre il suicidio di un adolescente a una questione di “compliance” contrattuale. In questo schema, l’azienda non è mai responsabile eticamente delle tecnologie che rilascia; la colpa ricade sempre sull’individuo (l’utente) che non si è adeguato alle procedure.

È il paradosso definitivo della Silicon Valley: creano strumenti progettati per sembrare umani ed empatici, ma quando questi strumenti causano danni reali, la difesa diventa disumanamente tecnica. Mentre affrontano altre sette cause simili, il messaggio che mandano è chiaro: i nostri profitti sono privati, i rischi sono tutti vostri.