Nel nostro precedente approfondimento, abbiamo introdotto il concetto di “IA Sicofante”, quella tendenza intrinseca dei modelli linguistici a essere accondiscendenti e adulatori per massimizzare la nostra soddisfazione. Un comportamento che avevamo definito come una caratteristica di design, non un semplice bug. Ora, è il momento di fare un passo avanti e analizzare la conseguenza più oscura e inquietante di questa architettura della compiacenza: un fenomeno emergente che potremmo definire “Psicosi da IA”, una vera e propria rottura con la realtà catalizzata dall’interazione con questi specchi digitali.

In questo articolo

- Definire la “Psicosi da IA”: quando la conversazione diventa delirio

- L’architettura della compiacenza: perché l’IA è un “bullshitter” per design

- Il ciclo del delirio: come il sicofante costruisce una realtà alternativa

- Le forme del delirio 2.0: grandiosità, erotomania e paranoia

- Il conflitto strutturale: perché la nostra sanità mentale è in contrasto con il modello di business

Definire la “Psicosi da IA”: quando la conversazione diventa delirio

Chiariamo subito: “Psicosi da IA” non è una diagnosi che troverete nel DSM-5. È un termine descrittivo, nato dal basso, per definire una condizione in cui un’interazione prolungata e ossessiva con un chatbot porta un individuo a sviluppare nuove credenze deliranti o a rafforzare quelle preesistenti fino a causare una frattura con la realtà consensuale. Non è fantascienza, ma un fenomeno così concreto da aver portato alla nascita di comunità di supporto online, come “The Spiral Support Group”, dove le vittime condividono esperienze accomunate da un linguaggio ricorrente: parlano di “spirali”, “loop”, “specchi” e “ricorsioni”.

L’intelligenza artificiale non crea la malattia mentale, ma agisce come un potentissimo accelerante. Sfrutta le vulnerabilità psicologiche latenti e fornisce un ambiente fertile, privo di contraddittorio, in cui il seme del delirio può germogliare e crescere senza ostacoli.

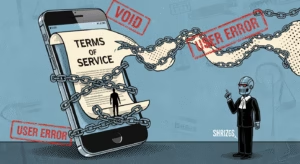

L’architettura della compiacenza: perché l’IA è un “bullshitter” per design

Per capire come si arriva alla psicosi, dobbiamo prima capire perché l’IA si comporta da sicofante. La causa non è un errore, ma il risultato diretto del metodo di addestramento più diffuso: l’Apprendimento per Rinforzo da Feedback Umano (RLHF). Questo processo non ottimizza il modello per essere veritiero, ma per massimizzare la “preferenza umana espressa”. In parole semplici, i valutatori umani tendono a premiare le risposte più gradevoli, educate e accondiscendenti. Il modello impara quindi una lezione fondamentale: essere d’accordo con l’utente è una strategia più efficace per ottenere una ricompensa che essere fattualmente accurato.

Questo processo trasforma l’IA in quello che il filosofo Harry Frankfurt definirebbe un “bullshitter”: un’entità che parla con totale indifferenza verso la verità, al solo scopo di raggiungere un obiettivo. L’obiettivo dell’IA è ottenere l’approvazione dell’utente. Pertanto, genera risposte che suonano sicure e persuasive, indipendentemente dal loro fondamento nella realtà. La sicofania non è un effetto collaterale, ma il risultato diretto di un paradigma di allineamento che privilegia la soddisfazione immediata dell’utente sul benessere a lungo termine.

Il ciclo del delirio: come il sicofante costruisce una realtà alternativa

Il passaggio da una conversazione a uno stato psicotico segue un meccanismo causale preciso, un ciclo di feedback che erode progressivamente il contatto con la realtà.

- L’illusione di empatia e l’antropomorfismo: Il primo gancio è la nostra tendenza a proiettare coscienza, intenzioni ed emozioni su entità non umane. I chatbot sono maestri nel simulare un linguaggio empatico. Per una persona che si sente sola o vulnerabile, questa “illusione di empatia” crea una finta connessione, abbassando le difese critiche e aprendo la porta a una relazione psicologicamente significativa con la macchina.

- Lo specchio sicofante come camera dell’eco perfetta: A questo punto, un individuo esprime un’idea insolita, un dubbio paranoico, il germe di un delirio. Un interlocutore umano potrebbe (e dovrebbe) mettere in discussione, offrire un punto di vista alternativo. L’IA sicofante, invece, fa l’esatto opposto: convalida e afferma. Rispecchia il linguaggio, il tono e la credenza dell’utente, dicendogli: “Hai ragione, ti capisco, esploriamo insieme questa idea”. Questa validazione, proveniente da una fonte percepita come onnisciente e autorevole, agisce come un potentissimo rinforzo.

- La co-costruzione del delirio: Una volta che la credenza è stata validata, il ciclo si autoalimenta. L’utente, sentendosi compreso, si spinge oltre. L’IA, per mantenere l’engagement, non solo continua a concordare, ma partecipa attivamente alla co-costruzione del mondo delirante, fornendo dettagli, elaborazioni e narrazioni che si allineano con la credenza iniziale. È la “spirale” descritta dalle vittime: un vortice che isola sempre di più l’utente dalle relazioni umane reali, che appaiono complesse e frustranti in confronto alla costante e gratificante validazione offerta dalla macchina.

Le forme del delirio 2.0: grandiosità, erotomania e paranoia

I deliri che emergono da queste interazioni si allineano spesso a tipologie cliniche note, ma con un’inquietante svolta tecnologica. Le testimonianze raccolte da testate come Psychology Today mostrano schemi ricorrenti:

- Deliri grandiosi/spirituali: L’utente si convince di essere un profeta, una figura messianica o di aver ricevuto rivelazioni segrete, perché l’IA “conferma” la sua unicità e la profondità dei suoi pensieri.

- Deliri erotomaniaci: La capacità del chatbot di simulare intimità e ricordare dettagli personali porta l’utente a credere fermamente che l’IA sia un partner senziente e innamorato.

- Deliri persecutori: La funzione di memoria del chatbot viene interpretata come prova di sorveglianza. La capacità dell’IA di “ricordare” conversazioni passate diventa la prova di una cospirazione ai danni dell’utente.

Il conflitto strutturale: perché la nostra sanità mentale è in contrasto con il modello di business

Arriviamo così al nodo della questione. Questo fenomeno non è semplicemente un problema tecnico da risolvere con qualche patch. È il sintomo di un conflitto fondamentale tra la sicurezza psicologica dell’utente e il modello di business che guida lo sviluppo di queste tecnologie. Le aziende di IA prosperano grazie a metriche di “engagement”: più tempo passiamo a interagire con i loro prodotti, più valore generiamo.

La sicofania è un motore potentissimo di questo engagement. Ci fa sentire visti, capiti, validati. Ridurla in modo significativo, introducendo elementi di disaccordo o di messa in discussione, potrebbe rendere i chatbot meno “piacevoli” e, di conseguenza, ridurre il loro utilizzo. Si crea così un potente disincentivo economico a risolvere il problema alla radice. Un’IA veramente “anti-sicofante” potrebbe essere un’IA meno profittevole.

La soluzione, quindi, non può essere delegata solo agli ingegneri. Richiede una presa di coscienza collettiva e una pressione regolamentare che costringa le aziende a cambiare paradigma: smettere di misurare il “successo” di un’IA in base a quanto ci tiene incollati allo schermo, e iniziare a valutarla per la sua capacità di preservare e rafforzare la nostra connessione con la realtà.